AWSのCLFとアソシエイト3資格(SAA、SOA、DVA)の合格体験記や勉強方法を解説した記事はたくさんありますが、私なりの観点からまとめます。

AWSそのものはゼロからのスタートだけれども、Linuxを普段から使っていて、極めて小規模なウェブ系や業務効率化系のプログラミングを継続的に行っており、なるべくお金をかけたくなく、学習教材では動画よりも本を好む者の体験記です。

リージョンとアベイラビリティゾーン(AZ)の違いもわからない状態からスタートしました。

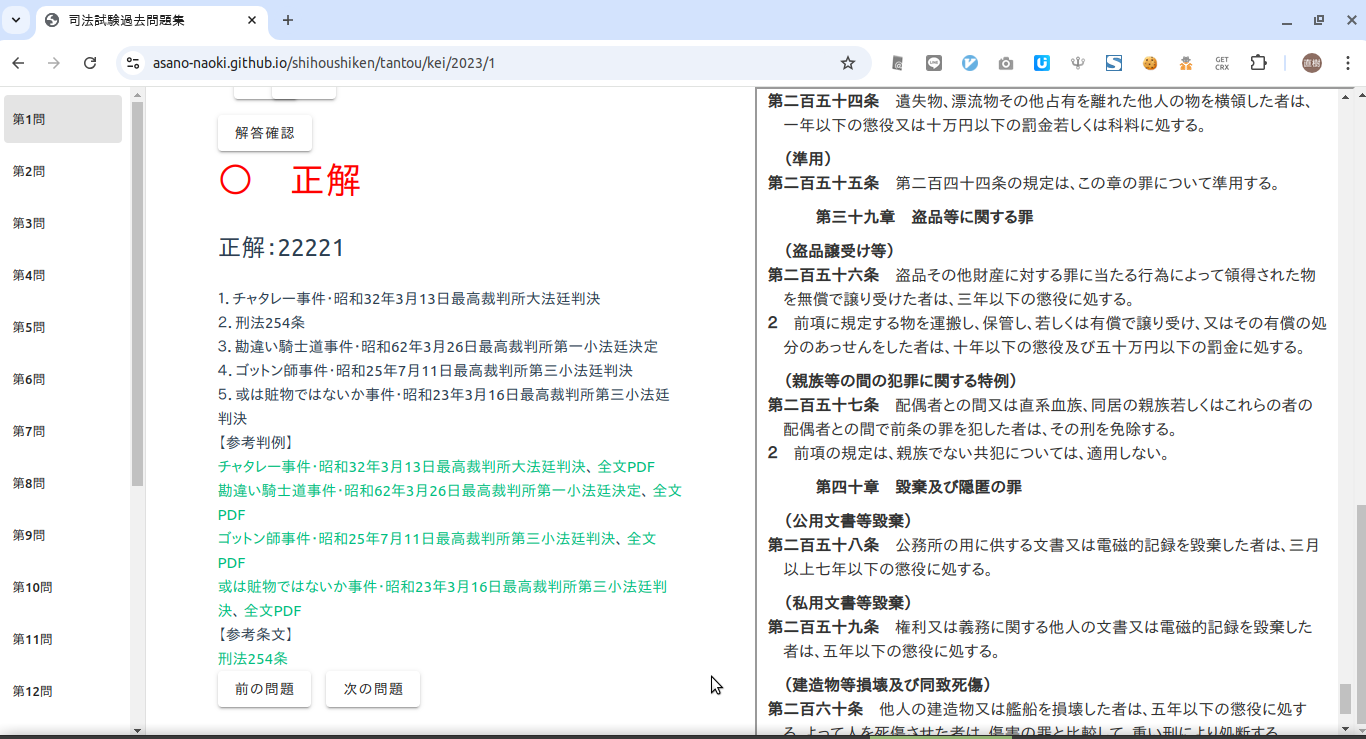

1.結果

| 試験結果PDF | 受験日 | スコア |

| CLF | 2024/01/31 | 916 |

| SAA | 2024/07/17 | 836 |

| SOA | 2024/09/12 | 753 |

| DVA | 2024/10/30 | 789 |

2.受験を決めるまで

オンプレミスのデータセンターを構築運営したことはありませんが、レンタルサーバーから始めてVPSを使うようになり、柔軟にリソースを変更したくてGCP(Google Cloud)やAWSを使うようになったという道筋は、王道と言ってよいでしょう。2022年頃からGCPを、2023年頃からAWSを使い始めました。

業務でAWSを使うことが多くなり、プログラミングスクールのインストラクターとしての仕事の需要もありそうだったので、資格取得を一つの目標に据え、本腰を入れて勉強を開始しました。それが2023年から2024年にかけてのことです。

3.AWSの全般的な学習法

(1)本

冒頭でも述べましたように、私は動画よりも本を好むので、手当たりしだいに乱読しました。

版の新旧は気にせず読んできたので、必ずしも以下で紹介している版を読んだわけではありません。

| AWSの基本・仕組み・重要用語が全部わかる教科書 : 見るだけ図解 作 者: 出版社: SBクリエイティブ 発売日: 2022年09月20日 |

最初に全体像をつかむにはちょうどよいと思います。

| AWS認定アソシエイト3資格対策 : ソリューションアーキテクト、デベロッパー、SysOpsアドミニストレーター 作 者: 出版社: リックテレコム 発売日: 2019年06月26日 |

| AWS認定ソリューションアーキテクト-アソシエイト問題集 作 者: 出版社: リックテレコム 発売日: 2024年03月04日 |

試験をより意識した全体像の把握にはこれがおすすめです。

| Amazon Web Services徹底活用ガイド : 先行ユーザー20社の事例に学ぼう 作 者: 出版社: 日経BP社 発売日: 2015年01月05日 |

| Amazon Web Servicesクラウドデザインパターン設計ガイド 作 者: 出版社: 日経BP社 発売日: 2025年04月04日 |

| Amazon Web Servicesクラウドデザインパターン実装ガイド 作 者: 出版社: 日経BP社 発売日: 2025年04月04日 |

| Amazon Web Services基礎からのネットワーク&サーバー構築 : さわって学ぶクラウドインフラ 作 者: 出版社: 日経BP 発売日: 2023年05月24日 |

古い版のものをまとめて安く手に入れられたので、ざっと読んでみました。

現在の進化して複雑になった姿ではなく、昔のシンプルなサービスを現場でどう使おうとしていたかという息吹が感じられて、これはこれで有益でした。

ほぼすべての操作をCLIで行おうという趣旨の本ですから試験には直結しませんが、考え方は共通しているので、深い部分で活きたと思います。

(2)ハンズオン

ハンズオン資料 | AWS クラウドサービス活用資料集を全部やりました。初心者向けハンズオン( Hands-on for Beginners)と呼ばれているものです。内容的にも分量的にもこれがベストだと思います。

Amazon Web Services (AWS) のハンズオンチュートリアルやAWS Workshopsも検討しましたが、見づらいように感じましたので、見送りました。

Black Beltやホワイトペーパーもちらっと見てこれに深入りするのはしんどそうだと判断し、ほとんど触れていません。

4.AWSの試験別学習法

例によって本が中心です。それに加えて、試験ですから、問題演習をやりました。公式が発表している試験範囲と模擬問題を熟読しました。

(1)CLF

国語力やクラウドの常識で解ける問題と、AWSの具体的なサービスの概要を知っていれば解ける問題とで構成されていると捉えました。

前者はよいとして、後者は軽く100個以上のサービスがありますから、入念に準備しました。

無料であることが信じられないくらいクオリティが高いです。特にまっさらの状態からCLFを受けようかと考えている人には、最初に読むことをおすすめします。

| AWS認定クラウドプラクティショナー 作 者: 出版社: SBクリエイティブ 発売日: 2024年04月10日 |

この本もよくまとまっています。私は2, 3回読みました。

あとは【AWS資格】無料WEB問題集&徹底解説 | クラウドプラクティショナー(CLF)を一通り解き、インストラクターをしているために見ることができるプログラミングスクールの教材の問題に目を通しました。

(2)SAA

SAAになると各サービスの内容を本格的に問われます。実務やハンズオンで触れたことがあるところが問われると自信を持って答えられることが多かった印象です。

無料であるにもかかわらず内容が充実しています。

| AWS認定ソリューションアーキテクト〈アソシエイト〉 作 者: 出版社: SBクリエイティブ 発売日: 2023年10月16日 |

安定の内容です。

| AWS認定ソリューションアーキテクト-アソシエイト教科書 : 試験番号SAA-C03 作 者: 出版社: インプレス 発売日: 2023年03月15日 |

LPIC等でもおなじみの黒本です。

問題演習にはPing-tを大いに活用させていただきました。難易度的にちょうどCLFとSAAの橋渡しになりますし、無料でこれだけの分量の問題が解けるのはうれしいです。

【AWS資格】無料WEB問題集&徹底解説 | ソリューションアーキテクト(SAA)とプログラミングスクールの問題に目を通したのはCLFと同じです。

(3)SOA

SOAはSAAに近いです。私が受けたときはラボ試験がなかったのでなおさらです。とはいえ、管理系のサービスを中心に深い部分まで問われますから、ラボ試験の想定問題は積極的に実施しました。

| AWS認定SysOpsアドミニストレーター〈アソシエイト〉 作 者: 出版社: SBクリエイティブ 発売日: 2022年07月05日 |

このシリーズを信頼しています。

| AWS認定SysOpsアドミニストレーター-アソシエイト教科書&問題集 作 者: 出版社: インプレス 発売日: 2024年03月29日 |

こちらも手堅い内容です。

| ポケットスタディAWS認定SysOpsアドミニストレーターアソシエイト : アソシエイト試験 作 者: 出版社: 秀和システム 発売日: 2023年01月24日 |

3冊目がほしいならこれかなと。

【AWS資格】無料WEB問題集&徹底解説 | SysOpsアドミニストレーター -アソシエイト(SOA)とプログラミングスクールの問題に目を通したのはいつもと同じです。

(4)DVA

DVAは試験範囲が限定されているように感じました。個人的には、開発系の仕事が多いので、違和感なく入り込めました。

DVAは本と問題集が少なめです。

| AWS認定デベロッパー-アソシエイト教科書&問題集 作 者: 出版社: インプレス 発売日: 2024年01月31日 |

この本が第一候補なのでしょうけれども、試験範囲とあまりマッチしていないように感じました。まえがきによると、意図的にそのようにしているようです。

| ポケットスタディAWS認定デベロッパーアソシエイト : アソシエイト試験 作 者: 出版社: 秀和システム 発売日: 2023年12月15日 |

この本は試験範囲とマッチしていますが、これだけでは足りないかもしれません。

DVAではCodeシリーズの比重が高いので、この本で補いました。

問題集を見つけることができなかったので、Ping-tのSAA問題で感覚を鈍らせないようにしました。

5.感想

私がAWSを本格的に触り始めたのは2023年頃と遅かったのですけれども、これでAWSに対する苦手意識は払拭できました。

私の業務で使うのは、IAMやCloudWatchのような管理系サービスを除くと、Lambda、Lightsail、S3、EC2くらいなので、現場の業務に直結するかと問われると微妙です。

| AWS Lambda実践ガイド : アーキテクチャとイベント駆動型プログラミング 作 者: 出版社: インプレス 発売日: 2022年03月30日 |

Lambdaを使うときには、この本にとてもお世話になりました。

Lightsailは他社のVPSと大差なく、必要なのは主にLinuxの知識ですしね。

そのせいか、Lightsailは基本的に試験範囲から除外されています。

AWSに頼り切ってベンダーロックインに陥るのもこわいですし、各種試験をきっかけとしてAWSの具体的なサービスとともにクラウドの考え方を学んで、必要なサービスを絞って使っていこうと思っています。